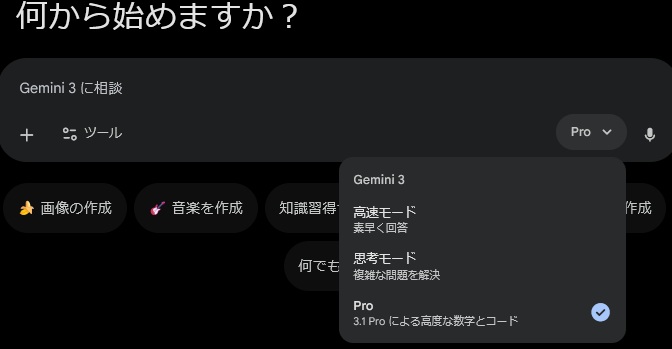

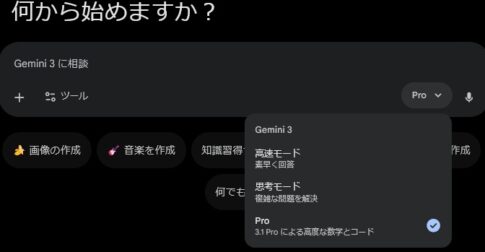

米国時間 2026年2月19日、Googleが Gemini 3.1 Pro を発表しました。位置づけとしては、Gemini 3系の頭脳の土台(コア推論)をグッと底上げして、一発で答えが出ない複雑なタスクを前へ進めるモデル、というところだと思います。

Gemini 3.1 Proの主な機能はこの6つ

- 推論力の底上げ(難問に強くなった)

ARC-AGI-2(※)で検証済みスコア 77.1% を達成し、Gemini 3 Proから大きく伸びた、とGoogleは説明しています。※ARC-AGIが、論理推論モデルにしか解けない問題を集めたものに対し、ARC-AGI-2は、人間にとっては解くのが容易だが、AIにとっては解くのが難しい問題を集めたものです。 - 考える品質改善+トークン効率アップ

- もっと根拠寄りで、事実の一貫性を上げる

- エージェント運用(ツール連携)を前提に最適化

- ネイティブ・マルチモーダル+超ロングコンテキスト

テキストだけじゃなく 画像・動画・音声・PDF まで入力でき、入力は最大 1,048,576トークン、出力は最大 65,536トークン。 - いろいろなところで使える(個人、開発、企業)

Geminiアプリ/NotebookLM/Gemini API(AI Studioなど)/Vertex AI/Gemini Enterprise…と、最初からいろいろなところで使えます。

推論強化は「ベンチの数字」だけじゃなく、使い道が具体的

Googleの公式では、Gemini 3.1 Proは単純な答えじゃ足りないタスク向けとのことです。例えば、

- 複雑なテーマを“図解っぽく”わかりやすく説明する

- バラバラのデータを統合して、意思決定しやすい形にまとめる

- クリエイティブ案件を段取り込みで前に進める

・・・みたいな、現場の困りごとに応えてくれます。

つまり、より賢くなったというよりも、段取りよく進めて終わらせることができるようになった、とでも言えるのではないかと思います。私もこれから使い込んでいきますので、何か気づいたら追記しようと思います。

画像・動画・音声・PDFまでOK、1Mトークン!

モデル仕様としては、ネイティブ・マルチモーダル路線を継続しつつ、1Mトークン級(!)の長文コンテキストを活かして、

- 長い資料(PDF)を丸ごと読ませて要約・比較

- 音声/動画を含む素材から、意味を落とさず整理

- 大きめのコードベースを前提に議論・修正案づくり

みたいな使い方ができるようになりました。これはすごいですよね~。これ、ちょっとした辞書になってしまいますよね。

誰が使えるのか?

個人ユーザー

Geminiアプリではモデル選択でProを選ぶ形で使えます。NotebookLMでもPro/Ultra向けに提供されました。

開発者・企業

Gemini API(Google AI Studio 等)や、Vertex AI / Gemini Enterprise、さらに Gemini CLI・Android Studio などにも広くプレビュー提供をするそうです。

まとめ

以上、取り急ぎ、ざっくりとまとめておきました。Gemini 3.1 Proは、ベストな1回答というより、複雑な仕事を、根拠立てしつつ、ツールも使いながら、段取りよく、最後まで進めていくという意味で徹底できるようになったという感じでしょう。

ただし、個人利用の場合は、入力したプロンプトやアップロードしたファイルが、Googleのモデル学習に使われる可能性が高いのは変わっていないようなので、個人利用の方は引き続きご注意下さい。